在互联网信息高度同质化的今天,搜索引擎对内容质量的评判标准日趋严苛。网站若想突破重复内容的桎梏,必须在原创性上构建护城河。这不仅关乎排名算法的青睐,更是建立用户信任、塑造品牌权威性的必经之路。

原创内容的核心价值

搜索引擎通过Simhash算法和I-Match技术识别文本特征,前者通过几何原理计算文本相似度,后者则通过保留核心关键词剔除干扰词。这些技术使得简单伪原创或段落重组难以逃脱重复判定。例如某电商网站因使用厂商模板描述,导致80%页面被标记为低质内容,整改后流量提升300%。

用户行为数据成为重要评判标准。谷歌的核心网页指标(LCP、FID、CLS)直接反映页面体验,当用户因内容雷同产生高跳出率时,算法将自动降低页面权重。某科技博客通过原创深度分析,用户停留时间从40秒延长至3分钟,搜索排名进入前五。

技术手段的精准应用

规范标签体系是消除重复的首道防线。在动态参数生成的电商页面中,Canonical标签可将数十个URL变体统一指向规范页面,避免权重分散。某家居网站应用此方法后,索引覆盖率从65%提升至92%。对于历史遗留的重复内容,301重定向需配合日志分析,某新闻门户通过定向跳转旧版页面,6个月内恢复70%流失流量。

结构化数据标记能增强内容辨识度。在问答类内容中添加FAQ schema,可使搜索引擎快速识别核心答案。某教育平台运用此策略后,精选摘要获取率提高45%。但需注意hreflang标签的规范使用,避免多语言站点产生地域性重复。

内容生产策略革新

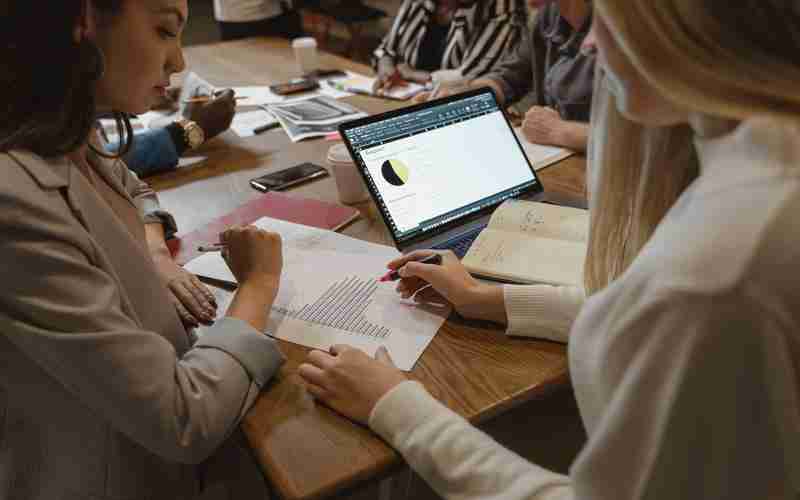

建立专题式内容矩阵可破解行业同质化难题。某医疗网站针对"糖尿病管理"主题,整合药物分析、饮食方案、运动监测等20个细分方向,形成内容闭环,专题页搜索流量占比达全站60%。深度访谈与数据可视化是差异化突破口,某财经媒体通过独家CEO专访+动态数据图表,原创内容被120家媒体转载。

用户生成内容(UGC)是天然的防重复屏障。某旅游平台引入达人游记系统,实时更新目的地实况,页面收录速度缩短至12小时。但需建立审核机制,某社区论坛因UGC质量失控,导致30%页面被判低质。

检测机制的动态部署

Siteliner等工具可扫描整站内容相似度,某跨境电商通过每周全站扫描,将重复率从35%压降至8%。但需注意导航栏等公共模块的排除设置,避免误判。Copyscape的跨站比对功能,曾帮助某出版社发现13个侵权站点,通过DMCA投诉挽回90%流量损失。

建立内容指纹库是长效解决方案。某媒体集团对十年稿件进行MD5加密存档,新增内容实时比对,原创率维持98%以上。配合AI查重系统,可识别语义级相似内容,误判率低于0.3%。

算法演进的应对策略

谷歌E-E-A-T准则中新增的"经验"维度,要求内容展现实践洞察。某健身APP上传300份用户体测报告,配合专业教练解读,页面权威性评分提升2.3倍。语音搜索优化需重构内容逻辑,将"如何快速减肥"类问题答案前置,某健康网站通过问答结构化改造,语音搜索流量增长180%。

视频内容成为新的原创战场。某美食博主将菜谱文字转为实操视频,平均观看时长达到文本页面的5倍。但需注意视频转录文本的独特性,某MCN机构因直接使用视频台词被判重复,整改后原创度达标。