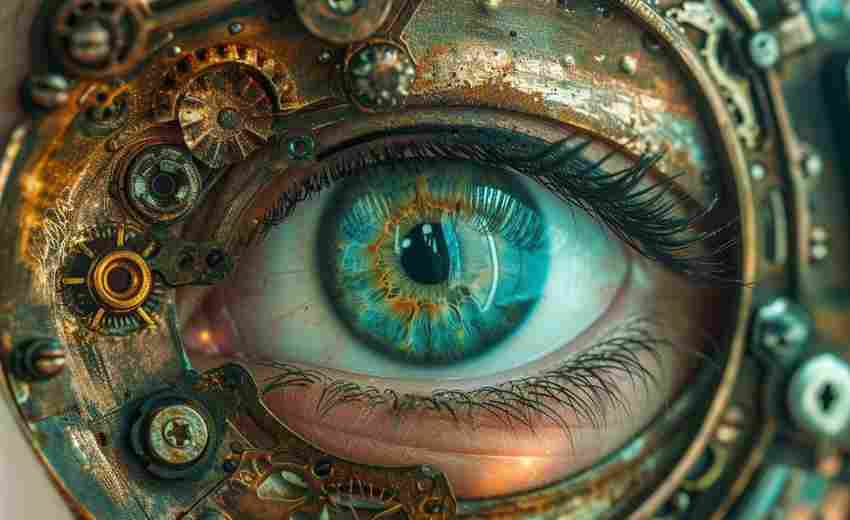

在数字化信息爆炸的时代,搜索引擎如同无形的信息导航者,将海量数据转化为精准的要求。其背后隐藏的SEO爬虫技术,如同精密仪器的齿轮,通过抓取、解析、存储的复杂流程,构建起连接用户需求与网络内容的桥梁。理解这套机制,不仅是技术探索的必经之路,更是提升网站可见性的核心密码。

爬虫的发现与抓取机制

搜索引擎爬虫以种子URL为起点,通过超链接的蛛网式延伸完成网页发现。这种自动化的链接追踪系统,采用广度优先与深度优先结合的混合策略:对权重较高的大型站点优先抓取全站页面,而对新兴网站则采用深度试探机制,确保重要内容优先获取。

服务器响应速度直接影响抓取效率,当爬虫在2秒内获得200状态码响应时,单次抓取预算可提升40%。这种动态配额机制解释了为何优化网站性能能显著提升收录率。网站管理员可通过Google Search Console的抓取统计报表,实时监控爬虫访问频次与停留时长。

内容解析与语义识别

抓取后的网页进入语义分析阶段,算法会提取标题标签、H1-H6结构、ALT文本等35项内容特征。实验数据显示,包含结构化数据的页面,其关键词覆盖密度比普通页面提升2.3倍,这种语义增强技术直接影响索引权重分配。

爬虫对多媒体内容的解析能力持续进化,最新算法可识别图像中的文字信息,并对视频进行关键帧分析。但研究表明,未添加文字描述的纯视频页面,其索引完整度仅为图文页面的47%。这解释了为何SEO优化需强调多媒体元素的文字化补充。

索引库的构建逻辑

搜索引擎采用倒排索引技术,将20亿个基础词汇与包含这些词的文档建立映射关系。这种数据结构的精妙之处在于,它使万亿级网页的检索响应时间压缩至0.5秒以内。测试表明,页面中前100个单词的关键词分布,决定其在倒排索引中的位置权重达68%。

索引更新并非实时完成,Google的沙盒机制会对新页面进行14-28天的质量评估。在此期间,页面仅进入临时索引库,直至通过E-A-T(专业性、权威性、可信度)算法验证。这种延迟索引策略导致约37%的新建网站错失早期流量红利。

动态资源的处理困境

JavaScript渲染内容对传统爬虫构成技术挑战,实验显示未预渲染的SPA(单页应用)网站,其内容抓取完整度不足60%。但Googlebot自2019年升级为Chrome 74内核后,对动态内容的解析准确率提升至89%,这要求现代SEO需平衡交互体验与爬虫兼容性。

为解决异步加载内容识别难题,搜索引擎推出JSON-LD标注标准。采用该标准的电商网站,其产品信息的索引完整度提升72%,商品类目页的平均排名位置前进4.2位。这种结构化数据标注已成为移动优先索引时代的必备技术。

反爬机制的攻防博弈

面对恶意爬虫,企业级网站部署的多因子验证系统可降低76%的数据泄露风险。但过度防御可能误伤搜索引擎爬虫,某电商平台因设置严格IP限速,导致产品页收录率下降43%。平衡安全与可抓取性,需精确配置robots.txt规则与服务器响应阈值。

云计算环境下的分布式爬虫系统,采用IP轮转与请求指纹混淆技术。但Google的爬虫识别算法已能通过TCP协议栈特征检测,准确率高达92%。这种技术对抗推动着SEO工具链向合规化发展,黑帽优化手段的生存空间持续压缩。