在数字经济的浪潮下,互联网平台的用户规模与业务复杂度呈指数级增长。电商大促瞬间涌入的亿级订单、社交平台突发热点引发的海量互动、在线教育万人同屏的实时课堂,这些场景对后端系统的并发处理能力提出近乎苛刻的要求。如何让系统在流量洪峰中保持优雅服务,成为技术团队必须攻克的难题。

架构横向扩展

分布式架构是应对高并发的基石。通过将单体系统拆分为订单、支付、库存等独立微服务,每个服务可单独部署与扩展,避免单一模块故障引发系统雪崩。阿里双11系统采用Spring Cloud Alibaba体系,借助Nacos实现动态服务发现,通过Sentinel进行流量控制,成功支撑每秒54.4万笔订单的创建。

服务拆分后的通信效率直接影响系统性能。采用gRPC替代传统HTTP协议,利用其基于HTTP/2的多路复用特性,可减少70%的RPC延迟。某头部短视频平台实践表明,在千万级QPS场景下,gRPC协议使服务间调用耗时从12ms降至3.5ms,显著降低线程阻塞风险。

缓存体系构建

合理的缓存设计可将数据库压力降低90%以上。采用多级缓存架构,本地缓存(如Caffeine)负责高频热点数据,分布式缓存(如Redis集群)处理跨节点数据共享。京东618大促期间,通过Guava Cache实现商品详情页本地缓存,使核心接口响应时间缩短至5ms内。

缓存穿透与雪崩是必须防范的风险。采用布隆过滤器拦截非法请求,对空值设置30秒短过期时间,可避免恶意攻击穿透数据库。某金融系统在Redis集群中实施随机过期策略,将缓存雪崩概率从0.3%降至0.01%以下,配合Hystrix熔断机制实现故障自动隔离。

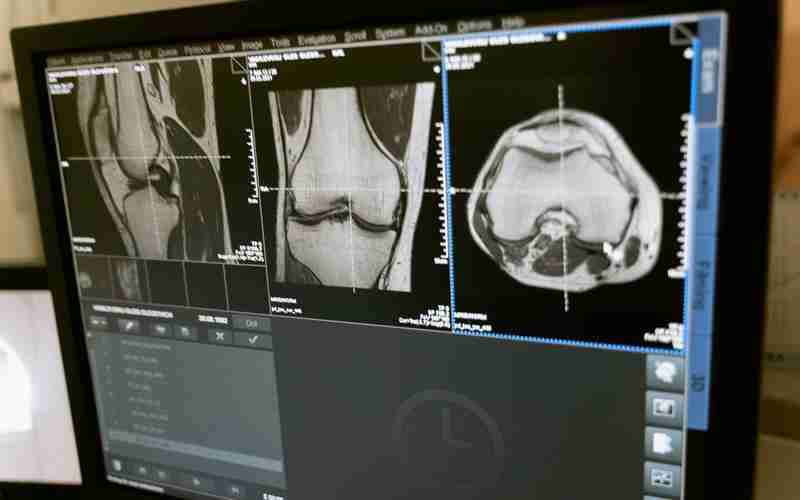

数据库性能优化

分库分表是突破单库瓶颈的关键手段。携程酒店业务采用TDDL中间件,将订单表按用户ID哈希分片到128个物理库,单个分片数据量控制在2000万行以内,使查询性能提升8倍。水平拆分时需注意全局ID生成问题,Snowflake算法配合数据中心编号,可避免分片数据冲突。

索引优化直接影响查询效率。通过EXPLAIN分析慢查询,某社交平台发现用户关系表的复合索引缺失导致全表扫描。建立(user_id, follow_time)组合索引后,2000万数据量的查询耗时从1.2秒降至23ms。定期使用pt-query-digest工具进行SQL审计,可消除潜在性能隐患。

流量调度策略

负载均衡算法选择直接影响资源利用率。Nginx加权轮询策略可根据服务器CPU核数动态分配请求,某视频直播平台实测该策略使集群吞吐量提升40%。对于需要会话保持的API服务,采用IP哈希算法确保同一用户请求始终路由到特定节点,避免分布式Session同步开销。

弹性扩缩容是应对突发流量的终极武器。基于Kubernetes的HPA(水平Pod自动伸缩)策略,当CPU使用率突破80%时自动扩容实例。某在线教育平台在课程抢购期间,50秒内完成从20个Pod到200个Pod的扩容,成功承载10倍流量冲击,活动结束后自动释放冗余资源。

异步处理机制

消息队列解耦是削峰填谷的利器。将订单创建与物流通知解耦,通过RocketMQ异步处理非核心流程。唯品会大促期间,消息队列堆积峰值达到2亿条,但核心交易链路仍保持200ms内响应。采用批量消费模式,单次处理100条消息,使数据库写入效率提升5倍。

线程池参数配置需要精细调优。通过Arthas监控发现,某支付系统默认线程池存在大量上下文切换。将核心线程数从200调整为100,队列容量从Integer.MAX_VALUE改为5000,配合CallerRunsPolicy拒绝策略,系统吞吐量反而提升15%,避免资源耗尽导致的雪崩效应。