在网站功能模块测试阶段,多方反馈意见的整合是确保产品符合用户需求、提升质量的关键环节。测试团队需要将来自开发、产品、用户等多维度的反馈纳入测试流程,通过系统化的方法筛选、归类并验证问题,最终形成有效的优化方案。这一过程不仅需要技术手段的支持,更依赖科学的流程设计与团队协作机制。

反馈收集机制的系统化

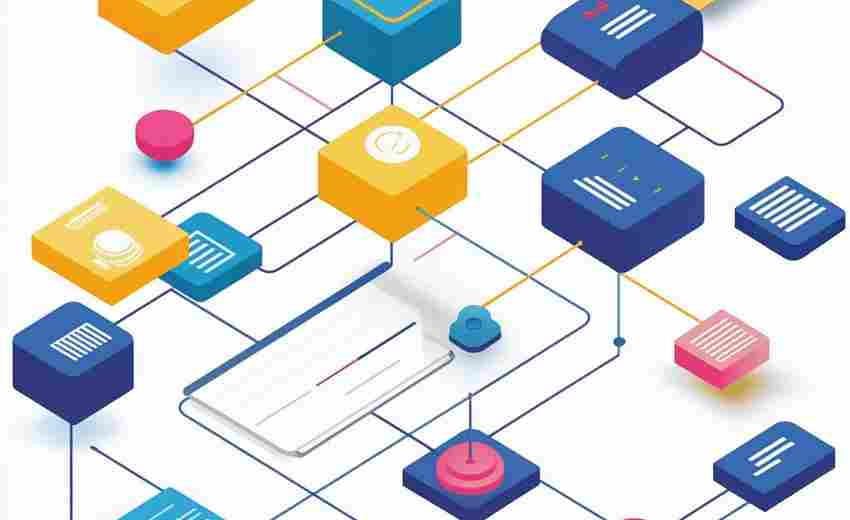

建立标准化的反馈收集渠道是整合多方意见的基础。测试团队需在需求评审阶段就明确反馈入口,例如在缺陷管理工具(如JIRA、PingCode)中设置专项标签,将开发人员的技术实现问题、产品经理的需求偏差反馈、用户的实际使用痛点进行分类存储。对于用户侧反馈,可通过埋点工具实时捕捉页面操作异常日志,结合自动化测试工具(如Selenium)复现问题场景,避免因描述模糊导致的信息失真。

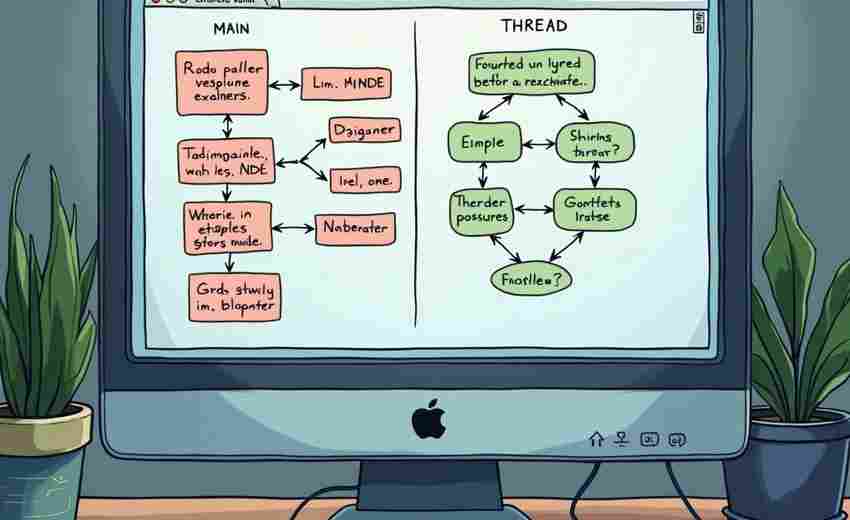

测试团队需建立跨部门反馈同步机制。例如在每日站会中,由测试负责人同步当前收集到的TOP3问题,并邀请相关方进行优先级评估。这种机制可避免“需求-开发-测试”三方的信息孤岛现象。某电商平台案例显示,通过将用户反馈中的“支付失败”问题与开发日志中的接口超时记录关联分析,团队在24小时内定位到第三方支付通道的兼容性问题。

多维度的反馈分析模型

反馈分析需要从功能实现、用户体验、技术风险三个维度展开。功能实现维度需验证反馈问题是否属于需求文档覆盖范围,例如用户提出的“订单状态更新延迟”可能涉及业务流程逻辑缺陷,需通过边界值测试验证接口响应时间。用户体验维度则需结合A/B测试数据,例如某社交网站在收到“消息提醒不明显”的反馈后,通过对比不同颜色方案的点击率数据,最终选择高对比度的设计。

技术风险维度侧重分析反馈问题的底层原因。测试团队可利用代码覆盖率工具(如JaCoCo)检查未被测试用例覆盖的代码块,结合用户反馈中的崩溃日志定位潜在缺陷。例如某金融系统在压力测试阶段未暴露问题,但用户反馈中频繁出现“交易超时”,最终通过代码审查发现数据库连接池未正确释放的隐患。

动态化的反馈处理流程

建立反馈处理的优先级矩阵是提升效率的核心。建议采用MoSCoW法则(Must have/Should have/Could have/Won't have)对问题进行分类,例如将导致系统崩溃的缺陷归为“紧急修复”,而界面文字错位则属于“优化改进”。某在线教育平台的实践表明,通过将70%的测试资源投入TOP5关键问题,使版本发布周期缩短了40%。

反馈验证需构建双重确认机制。技术团队修复问题后,除常规冒烟测试外,应邀请原始反馈提供者参与验收。例如某门户网站针对“文件上传格式限制不明确”的反馈,不仅修正了后端验证逻辑,还让提出该问题的市民代表参与UI提示语的确认,使整改通过率提升至98%。同时建立反馈知识库,将典型问题的解决方案标准化,目前头部互联网企业的知识库平均可解决60%的重复性问题。

透明化的反馈闭环构建

建立可视化的问题追踪看板能够增强各方参与感。测试团队可使用燃尽图展示问题解决进度,通过颜色编码区分不同来源的反馈。某医疗系统项目的实践显示,当用户看到自己提交的“病历导出乱码”问题在看板上从红色(待处理)变为绿色(已解决)时,用户满意度提升了35%。

定期发布反馈处理报告是维持信任的关键。报告应包含问题分布热力图(如功能模块缺陷密度)、解决时效分析(平均修复周期)、遗留风险说明等内容。某跨境电商平台通过月度报告披露“购物车商品丢失”问题的根本原因——分布式锁机制缺陷,不仅获得用户谅解,还推动了技术架构的升级。