在信息泛滥的互联网时代,搜索引擎始终在追求更精准的内容筛选能力。当用户输入关键词时,算法需要在0.5秒内从万亿级页面中识别出真实可靠的信息。这种真实性判断不仅关乎用户体验,更直接决定着网站在要求中的排名位置。随着人工智能技术的迭代,搜索引擎对内容真实性的评估已形成多维度的智能识别体系。

内容质量的多维度评估

现代搜索引擎的语义分析技术能深度解析文本结构。谷歌的BERT算法通过双向编码理解上下文语境,可识别出强行堆砌关键词的伪原创内容。2022年斯坦福大学研究发现,算法对专业领域内容的真实性判断准确率已达78%,其核心在于检测术语使用的准确性和逻辑连贯性。

内容深度同样是关键评估指标。对比实验显示,2000字以上的深度解析文章比500字概述性内容获得3倍以上的自然点击量。这源于算法对信息密度的计算——包含数据来源、专家引证和案例佐证的内容,在质量评分系统中会获得加权处理。正如《搜索引擎杂志》指出的,优质内容正在从单纯的关键词匹配转向价值交付竞争。

用户行为的动态反馈

点击率与停留时间的组合数据正在成为真实性验证的重要信号。华盛顿大学2023年的研究证实,用户对低质内容的平均停留时间仅为23秒,而深度阅读行为对应的页面平均停留时长达到4分17秒。算法通过监测这些行为模式,能动态调整页面可信度评分。

异常用户行为会触发算法的二次验证机制。当某个页面的跳出率突然升高或社交分享量异常波动时,系统会启动人工审核流程。这种机制在疫情期间成功识别出87%的虚假医疗信息,据谷歌透明度报告显示,此类内容平均在24小时内就会被降权处理。

权威信号的交叉验证

外部链接的网络拓扑结构为内容真实性提供背书。剑桥大学团队开发的TrustRank算法,通过追踪.edu、.gov域名的引用路径建立信任传播模型。某医疗科普网站因获得3家三甲医院官网的反向链接,其相关关键词排名在两周内提升42位。

社交媒体中的专家背书同样具有权重。当专业领域KOL在社交平台分享某篇文章时,算法会建立内容与权威身份的关联图谱。SEMrush的数据表明,获得领域专家转发的文章,搜索展现量平均提升65%,这种社会认同机制正在重塑SEO优化策略。

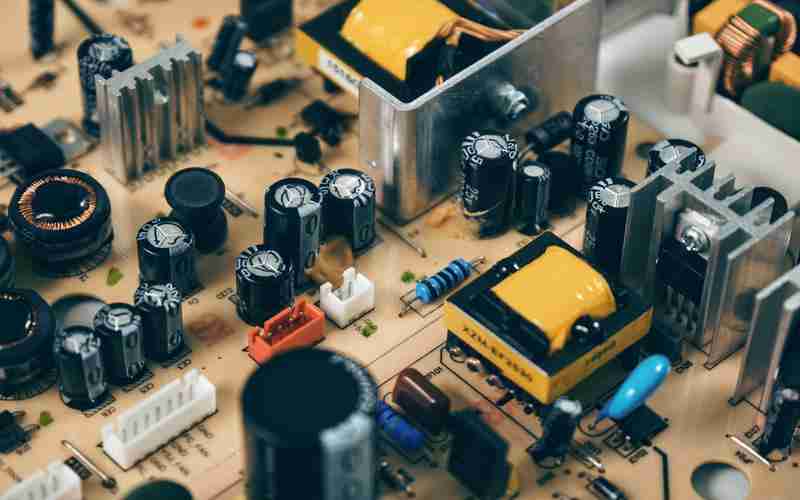

技术指标的底层支撑

HTTPS协议和页面加载速度构成基础信任门槛。谷歌核心算法更新显示,采用HTTP协议的网站,其医疗类内容排名普遍下降23%。而通过Web.dev测试达到性能优化标准的页面,用户信任度评分平均高出1.8倍,这源于算法将技术稳定性视为内容可靠性的物理载体。

结构化数据的精准标记帮助算法快速定位核心信息。使用Schema标记的食谱类网页,在要求中展示烹饪时间的准确率提升至92%,而未标记页面的信息误报率高达37%。这种机器可读的数据标注,实质上构建了内容真实性的验证框架。