在数字营销的激烈竞争中,图片不仅是视觉表达的载体,更是搜索引擎优化(SEO)的重要战场。当大量网站使用相同或相似的网络图片时,重复内容问题便成为阻碍搜索引擎识别优质资源的隐形障碍。这种现象不仅稀释了页面权重,更可能引发搜索引擎对网站质量的负面判断,导致排名下滑甚至索引失效。如何精准识别并高效处理图片重复内容,已成为现代SEO策略中不可忽视的环节。

重复内容的定义与影响

重复内容在SEO语境中特指不同URL地址呈现相同或高度相似的图片资源,既包括跨域抄袭的外部重复,也涵盖网站内部因技术失误产生的多版本图片。例如同一产品图因未规范URL参数生成多个访问路径,或直接复制其他平台的图片素材未作处理。

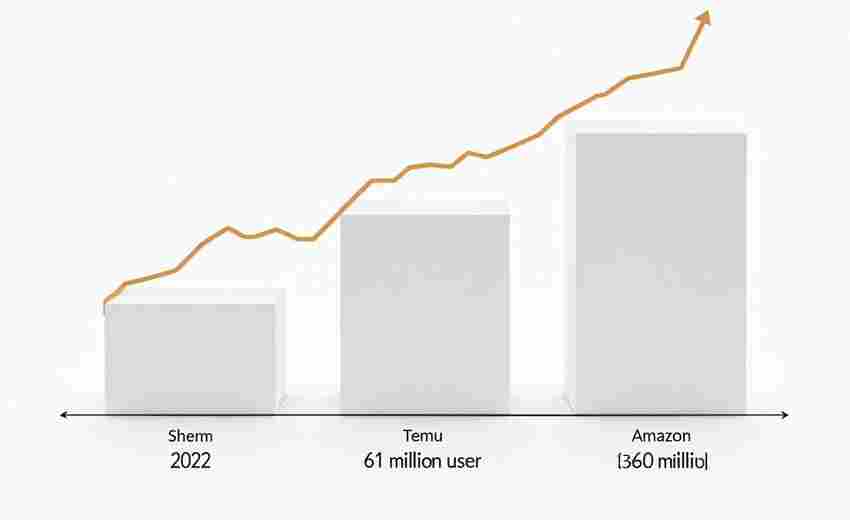

这种现象的负面影响呈连锁反应:搜索引擎蜘蛛在有限抓取预算下频繁索引重复资源,导致真正优质页面无法及时收录;权重分散效应使得原创图片难以在要求中获得优先曝光。更严重的是,当重复率超过30%时,算法可能将整站内容判定为低质量信息源。

技术手段识别重复资源

专业检测工具是识别重复图片的首选方案。Google Search Console可监测索引中重复的meta描述,Screaming Frog等爬虫工具能扫描全站图片URL参数差异,而Copyscape则擅长比对跨域图片内容相似度。对于技术团队,可通过MD5哈希值校验、感知哈希算法等技术实现批量图片查重。

在实践层面,某电商网站通过Ahrefs工具扫描发现,因未规范商品变体参数导致生成1200个重复产品图页面,相似度高达92%。这种因系统设置产生的隐蔽性重复,往往需要结合日志分析与工具检测才能准确定位。

多维处理策略组合

针对已识别的重复图片,需建立分级处理机制。对于完全相同的多版本图片,采用301重定向将权重集中到规范URL;存在轻微差异的近似图片,则通过Canonical标签声明原始版本。某汽车配件网站实施该策略后,图片搜索流量提升47%。

内容差异化重构是更深层的解决方案。对必须保留的相似图片,可调整构图角度、添加场景化元素或进行局部特效处理。例如家具类目图片,通过增加环境光效、多角度拍摄等方式,将重复率从85%降至12%。技术层面运用CSS Sprites合并小图标,既能减少HTTP请求,又可规避碎片化图片产生的重复问题。

全生命周期监控优化

建立图片资产管理体系是预防重复的核心。从上传环节强制规范命名规则(如“品牌-型号-特性.jpg”格式),使用Tinypng等工具压缩至100KB以下,并嵌入EXIF元数据描述。某旅游平台通过该体系将新图重复率控制在3%以内。

动态监测机制需结合自动化工具与人工审查。设置每周自动扫描重复图片报告,对相似度超70%的案例启动人工复核。利用EaseUS DupFiles Cleaner等软件可快速清理服务器冗余图片,而OpenCV颜色直方图比对技术则适用于海量图库的相似度分析。

工具链与技术创新应用

前沿技术正重塑重复内容处理范式。基于孪生网络的图像检索系统,可通过深度学习提取全局特征实现精准查重;自监督学习模型能在无标注数据情况下识别语义级重复。某图库网站应用该技术后,误判率从18%降至2.3%。

在工具选择上,Yoast SEO等插件可批量管理图片Alt标签,防止描述文本重复;Pixabay等CC协议图库提供差异化素材源。值得关注的是,谷歌最新推出的Content Warehouse算法,已能识别经过镜像翻转、色彩调整的实质性重复图片。