在搜索引擎优化的技术架构中,XML网站地图如同航海图般指引着爬虫高效索引网站内容。错误的站点地图可能导致搜索引擎对页面收录不全甚至误判网站质量。从格式错误到动态更新失效,每一个细节都可能成为阻碍流量增长的隐形障碍。

格式验证与结构规范

XML文件必须严格遵守W3C标准,任何格式偏差都会导致解析失败。网页11的案例显示,某网站因_function.php文件末尾存在多余的空行,导致XML声明偏离首行位置,触发"XML declaration allowed only at the start"错误。这种因代码文件格式问题引发的连锁反应,往往需要开发者逐行检查服务器配置文件。

特殊字符处理是另一大隐患。网页33记录的案例中,未转义的&符号直接破坏了XML结构完整性。例如产品描述中的"AT&T"必须转义为"AT&T",否则解析器会在该位置抛出实体引用错误。使用在线验证工具(如XMLValidation)扫描时,系统可精准定位到出现问题的行号与列号,极大提升排查效率。

内容完整性排查

死链与重复链接会显著降低站点地图的可信度。某电商平台曾因商品下架未同步更新站点地图,导致30%的链接返回404状态码,这种情况可通过Screaming Frog等爬虫工具批量检测(网页48)。工具生成的报告会标注失效链接的HTTP状态码,帮助运营人员快速定位过期页面。

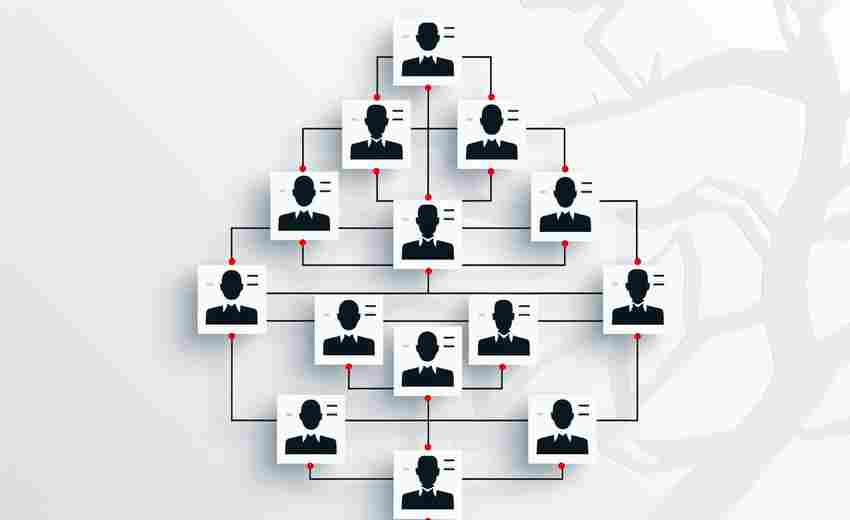

对于大型内容网站,单个站点地图超过5万个URL或50MB时,必须进行拆分。网页12的研究表明,分层式站点地图索引可将爬虫抓取效率提升40%。主站点地图index.xml中仅包含子地图路径,每个子地图严格遵循容量限制,这种结构尤其适合新闻门户或电商平台。

动态更新与版本控制

WordPress等CMS平台常因插件冲突导致动态站点地图失效。网页14披露的案例中,Yoast SEO与缓存插件的不兼容,使得生成的sitemap.xml被注入HTML代码。解决方法包括:禁用插件逐一排查,或在wp-config.php中强制关闭OB_START缓冲机制。

版本控制是预防更新事故的关键措施。某技术博客在Git版本库中保留近三个月的站点地图历史版本,当发现索引异常时可快速回滚。网页8建议结合CI/CD流程,在每次内容更新后自动生成差异比对报告,确保新增页面及时纳入索引体系。

工具辅助与自动化监测

Google Search Console提供最直接的错误反馈渠道,其"覆盖率报告"能显示未被索引页面的具体原因(网页48)。配合DeepCrawl等第三方工具,可实现每周自动扫描并邮件预警。某金融网站通过设置自动化监测脚本,将站点地图错误响应时间从72小时缩短至15分钟。

对于多语言站点,工具组合运用尤为重要。XML-生成的站点地图可自动标注hreflang标签,配合SEMrush进行国际SEO诊断,能有效避免区域页面重复收录问题。网页42提到的Nmap工具虽主要用于安全扫描,但其端口监控功能可同步检测站点地图文件的HTTP响应状态。