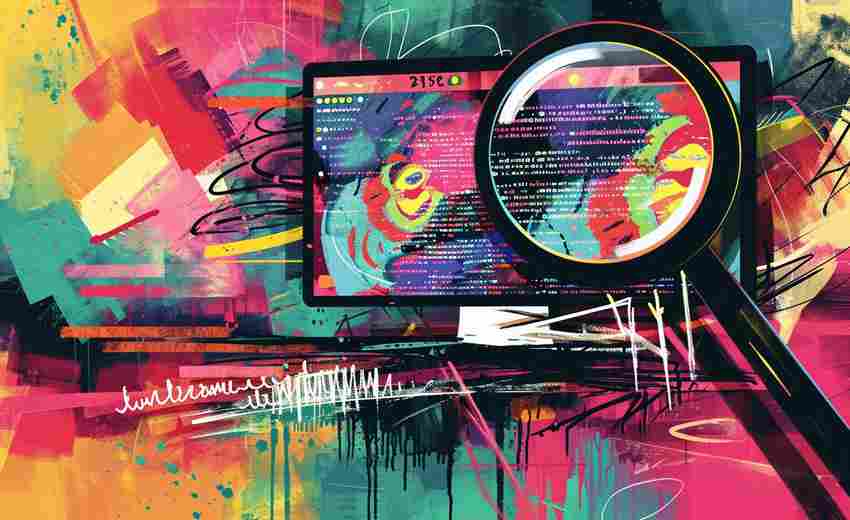

网站技术问题对SEO的影响主要体现在以下方面,这些缺陷会直接导致搜索引擎抓取障碍、页面权重分散或用户体验下降:

一、服务器与抓取层面的技术缺陷

1. 服务器配置错误

服务器错误配置(如robots.txt限制过严、DNS解析异常)会导致爬虫无法正常索引页面内容,甚至误判网站为不可访问状态。若动态页面生成时出现数据库连接错误或代码异常,同样会引发大量404错误。

2. 爬虫陷阱与索引效率低下

无限循环目录结构、未规范化的URL参数、JS渲染内容未预加载等技术问题,会造成搜索引擎资源浪费。据统计,30%以上的无效抓取源自网站结构设计缺陷。

二、页面层技术优化缺失

3. 加载速度不达标

未压缩的媒体文件(超过500KB的图片)、冗余CSS/JS代码、未启用CDN加速等技术疏忽,会导致页面加载时间超过3秒的行业,直接影响搜索排名。

4. 移动端适配失效

缺少响应式设计、视窗设置错误、触控元素间距过小等技术问题,使得移动端用户体验评分下降50%以上,这在Google移动优先索引机制下会造成排名断崖式下跌。

三、结构化数据异常

5. Schema标记错误

错误的JSON-LD格式、重复的微数据标记、过时的产品信息标注等技术性错误,会导致搜索引擎对页面内容的理解偏差。约15%的富媒体摘要消失案例源于标记错误。

6. 规范链系统混乱

未正确使用canonical标签导致的重复内容,以及错误的重定向链(如多次302跳转),会使页面权重分散。实验数据显示,这种技术失误可使页面排名下降5-8个位次。

四、安全与稳定性缺陷

7. HTTPS证书异常

过期的SSL证书、混合内容警告(HTTP与HTTPS资源共存)等技术漏洞,不仅触发浏览器安全警告,还会导致要求的「不安全」标识,使点击率下降18%-25%。

8. 网站可用性波动

每月超过3次的服务器宕机(每次持续30分钟以上),或频繁出现504网关超时错误,会被搜索引擎判定为低质量站点。这类技术故障可使索引量减少40%以上。

注:以上技术问题需通过日志分析(抓取诊断)、Lighthouse性能检测、Search Console覆盖率报告等工具进行系统性排查,建议建立自动化监控机制。