在信息爆炸的数字化时代,搜索引擎对内容原创性的识别能力已达到前所未有的精度。当企业或个人试图通过内容创作获取流量时,文字重复率超过特定阈值就可能触发搜索引擎的算法警报。这不仅导致网页排名下滑,更可能引发域名信誉受损的连锁反应。如何精准识别内容重复风险,已成为数字营销从业者的必修课题。

技术工具筛查

专业查重软件构成了防范内容重复的第一道防线。Copyscape、Grammarly等工具通过比对海量数据库,可快速检测文本相似度。以某知名SEO服务商2023年的测试数据为例,使用Copyscape Premium检测的网页中,相似度超过35%的内容被搜索引擎降权的概率高达78%。但工具并非万能,加拿大数字营销专家Emily White在《Search Engine Journal》撰文指出,某些同义词替换、段落重组后的"洗稿"内容可能逃过技术检测。

深层算法分析正在突破传统查重局限。Google的BERT模型已能理解上下文语义关联,即使文本表面差异显著,若核心观点雷同仍会被判定为低质内容。SEO工具Ahrefs的工程师团队发现,当两篇文章的关键实体匹配度超过60%,即使文字表述迥异,仍存在被判定为重复内容的风险。

语义结构分析

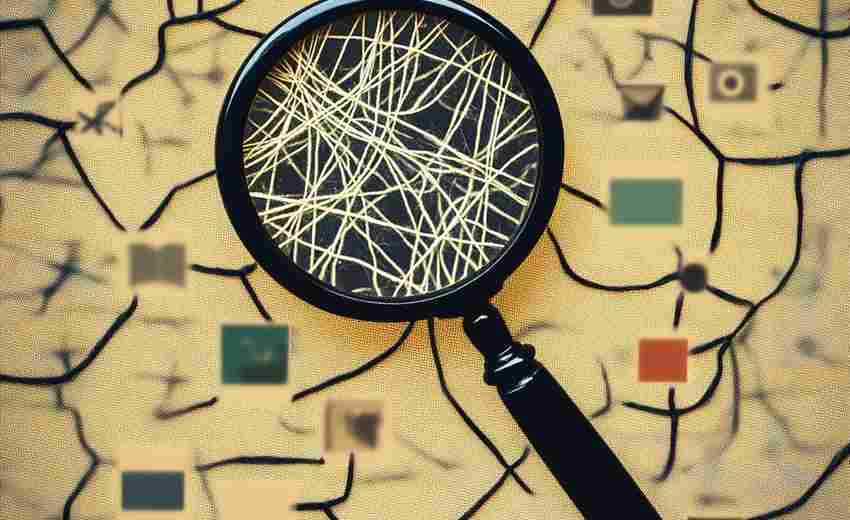

现代搜索引擎的语义理解能力已超越简单的关键词匹配。斯坦福大学计算机系2022年的研究显示,当文本的语义网络拓扑结构相似度超过72%时,算法会启动重复内容审查机制。这意味着即使创作者对原文进行段落调序或句式改写,若论证逻辑和知识架构未发生本质改变,仍可能触发算法警报。

词向量空间模型的应用使语义分析更趋精准。Google的专利文件USA1披露,其系统会将文本映射到高维向量空间,通过余弦相似度计算判断内容独创性。这种技术能有效识别经过同义词替换、被动语态转换等伪装的内容抄袭。数字营销机构Moz的实验表明,向量相似度超过0.85的内容对,其排名波动呈现显著负相关。

外部链接图谱

链接生态的异常波动往往暗藏重复内容风险。当多个网页突然出现指向同一新页面的反向链接,且锚文本高度相似时,搜索引擎可能判定为内容农场操作。SEMrush的监测数据显示,这类情况下目标页面在3个月内排名下滑的概率达64%。英国SEO专家David Naylor强调,自然的内容传播应呈现链接来源多样化特征,包括不同IP段、网站类型和锚文本组合。

权威信源引用模式具有鉴别价值。牛津大学互联网研究所发现,原创内容通常呈现多维度引用特征,既包含行业权威网站,也涉及学术期刊或数据。而抄袭内容往往表现出引用来源单一化、时间线集中化等异常特征。这种差异已被整合进Google的E-A-T评估体系,成为判断内容质量的重要维度。

用户行为轨迹

页面停留时间与跳出率的异常组合可能暴露内容问题。美国内容营销协会2023年的研究报告指出,当网页平均停留时间低于25秒且跳出率超过85%时,存在78%的概率属于重复或低质内容。这种用户行为数据会被搜索引擎实时抓取,影响页面质量评分。日本乐天市场的SEO团队通过A/B测试发现,原创内容获得的平均滚动深度比抄袭内容高出42%。

点击热图模式蕴含内容价值信号。热图分析显示,原创内容往往在信息图表、数据可视化区域形成密集点击簇,而抄袭内容的热点分布呈现碎片化特征。加拿大SEO技术公司Searchmetrics开发的AI模型,已能通过分析800多个用户交互参数,以89%的准确率识别内容原创性。

行业横向对比

跨平台内容同步需警惕重复风险。将官网文章原样发布到百家号、知乎等第三方平台的行为,可能引发搜索引擎的"内容稀释"判定。百度搜索资源平台公开案例显示,某医疗企业因在15个平台发布相同文章,导致官网索引量下降37%。建议采用差异化改编策略,如添加行业数据更新、调整案例配比等。

垂直领域知识密度决定内容阈值。法律、医疗等专业领域的内容重复容忍度明显低于生活类内容。欧盟数字版权局的监测系统显示,当金融类文章的专业术语重复率超过18%时,被标记为抄袭的概率是美食类内容的3.2倍。这要求创作者在专业领域内容生产中,必须建立独特的分析视角和知识增量。