在互联网技术高速发展的今天,网站机房作为支撑在线业务的核心基础设施,其硬件设施的区域节点布局直接影响着数据处理的效率、系统的稳定性以及长期运营成本。合理的规划不仅需要兼顾技术的前瞻性与实用性,还需从地理环境、网络架构、能源管理等多维度进行综合考量,才能实现资源利用最优化与业务可持续增长的双重目标。

选址与空间规划

地理选址是机房布局的首要考量。根据国家标准《数据中心设计规范》,机房需远离强电磁干扰源(如高压线路、微波发射塔)及腐蚀性气体区域,并优先选择地质结构稳定、自然灾害风险低的区域。例如,某北京核心商业区机房选址时,通过分析周边交通便利性(距机场18公里)与配套设施完备性,确保了运维人员的高效出入与应急资源供给。

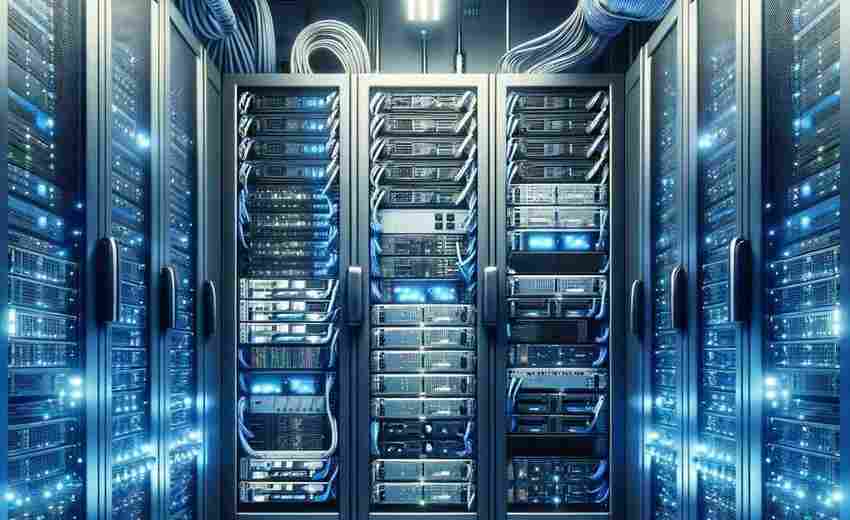

空间规划需遵循功能分区原则。通常将机房划分为主机房、辅助区(如监控室)、支持区(配电室)等独立区域。以某云计算中心为例,其采用后排机柜用于网络迁移、前排机柜用于服务器集群的分区策略,并设置电源列头柜与网络配线柜实现电力与信号的集中管理。这种布局既能避免设备间的电磁干扰,又能缩短线缆传输距离,降低信号衰减风险。

设备布局与散热设计

硬件设备的物理排列直接影响运维效率与能耗水平。服务器、存储设备等核心组件应按功能模块分组,例如将高密度计算节点集中布置以形成“计算热区”,而网络交换设备则靠近机房边缘便于线缆接入。某金融数据中心采用“冷热通道隔离”技术,通过机柜背对背排列形成封闭冷通道,使空调送风效率提升30%,PUE值(电能使用效率)降至1.25以下。

散热系统的规划需匹配设备发热特性。采用下送风精密空调时,防静电地板高度需达到400mm以上以保证气流畅通,同时在地板夹层铺设20mm橡塑保温棉防止冷凝。对于高热负荷区域,可引入液冷技术,如某人工智能机房在GPU集群中部署浸没式液冷系统,单机柜功率密度提升至50kW,较传统风冷节能40%。

网络架构分层部署

网络拓扑需遵循“核心-汇聚-接入”三级架构。核心层采用万兆交换机实现跨区域数据高速交换,某电商平台在华北、华东节点间部署OTN光传输设备,使跨区数据延迟控制在5ms以内。汇聚层则配置支持SDN(软件定义网络)的智能交换机,通过动态流量调度应对突发访问峰值,如某视频网站在春节流量洪峰期间成功避免服务器过载。

布线系统需符合ANSI/TIA-942标准。主干链路使用OM4多模光纤确保10Gbps传输速率,水平布线采用CAT6A屏蔽双绞线以抑制电磁干扰。某政务云平台在机柜顶部安装垂直理线槽,配合彩色标签管理系统,使故障定位时间缩短70%。值得注意的是,光纤与电源线需分槽敷设,水平间距不小于30cm,避免交叉干扰导致的信号失真。

安全防护体系构建

物理安全需实现多重防护。某省级数据中心在入口处设置生物识别门禁系统,机房内部采用红外电子围栏划分安全等级区域,重要机柜加装震动感应装置,非法触碰即时触发声光报警。电力安全方面,采用双路市电接入与柴油发电机冗余配置,某互联网企业机房通过2N架构UPS系统实现99.999%供电可靠性,年故障时间小于30秒。

网络安全需实施纵深防御。在边界部署下一代防火墙与入侵检测系统(IDS),内部通过VLAN划分隔离业务系统。某金融机构采用“零信任”模型,对服务器实行微隔离策略,成功阻断APT攻击渗透。防雷接地系统需达到10Ω以下接地电阻,信号线安装SPD浪涌保护器,避免雷击导致硬件损毁。

绿色节能技术应用

能源管理需贯穿全生命周期。采用变频精密空调与自然冷却相结合,某内蒙古数据中心利用年均气温8℃的气候优势,每年有3200小时可关闭压缩机,仅凭室外空气实现冷却,年节电量达1200万度。配电系统引入AI能效优化算法,实时分析PDU用电数据,某云计算平台通过动态调整服务器负载分布,使整体能效比提升18%。

硬件选型聚焦低功耗特性。优先选用80PLUS钛金认证电源,CPU采用可调节TDP(热设计功耗)型号。某视频网站将老旧服务器替换为基于ARM架构的定制化芯片,单台功耗从450W降至220W,性能密度反而提高1.6倍。模块化UPS可随负载增长逐步扩容,避免初期投资浪费,某中型企业机房通过此方案节省前期成本35%。

可扩展性预留设计

空间预留需满足未来5-10年扩容需求。某产业园区机房在建设时预留30%空置机柜位,并在配电系统中预埋1600A母线槽,后续扩容仅需增加模块化UPS即可支持200个新机柜接入。网络架构设计需支持平滑升级,如某运营商在部署100G核心交换机时,提前铺设单模光纤为400G光模块升级预留通道。

技术迭代兼容性同样关键。采用开放式机架标准(OCP),支持不同厂商设备混插。某互联网公司通过定制开放式机柜,将服务器部署密度从15台/柜提升至42台/柜,空间利用率提高180%。建筑结构方面,某新建数据中心采用12米层高设计,为未来液冷管道与机器人巡检系统安装预留立体空间。