在数字营销的浪潮中,搜索引擎优化始终是争夺流量高地的核心战场。随着算法日益智能化,机械式的关键词填充不仅无法提升排名,反而可能成为阻碍内容与用户需求匹配的隐形枷锁。当关键词密度突破合理阈值时,这种看似取巧的策略实则扭曲了信息的本质表达,使搜索引擎难以从冗余重复的符号中捕捉真实的搜索意图。

关键词堆砌破坏内容质量

过度堆砌关键词会直接导致内容可读性断崖式下跌。当"SEO优化"等核心词汇在百字内反复出现十余次,文本的语义连贯性将被肢解为碎片化的字符组合。这种违背语言逻辑的创作方式,本质上是对信息传播规律的破坏。研究表明,关键词密度超过5%的网页,用户平均停留时间下降37%,跳出率上升至82%。

搜索引擎对内容的评估早已超越简单的词频统计。谷歌的BERT算法通过双向编码技术分析上下文关联性,能够识别出强行插入关键词导致的语义断层。例如在讨论"移动端适配"的文章中,每段都重复该词汇会导致算法误判内容主题,反而弱化"响应式设计""用户体验"等相关概念的权重。

干扰搜索意图识别机制

现代搜索引擎的核心使命是破解用户搜索行为背后的真实需求。当关键词密度异常时,算法在解析"如何选择登山鞋"这类查询时,可能被页面中高频出现的"户外装备"干扰,误将本应聚焦于"鞋类选购指南"的内容归类至更宽泛的产品目录页面。这种偏差直接导致搜索排名与用户需求的错位。

搜索引擎的意图识别系统依赖语义网络构建知识图谱。过度优化的页面会形成畸形的语义结构,例如在母婴用品页面堆砌"婴儿奶粉"关键词,可能使算法误认为内容涉及"奶粉配方分析"而非"育儿知识科普"。这种偏差在医疗、法律等专业领域尤为危险,可能引发信息误导风险。

触发算法惩罚机制

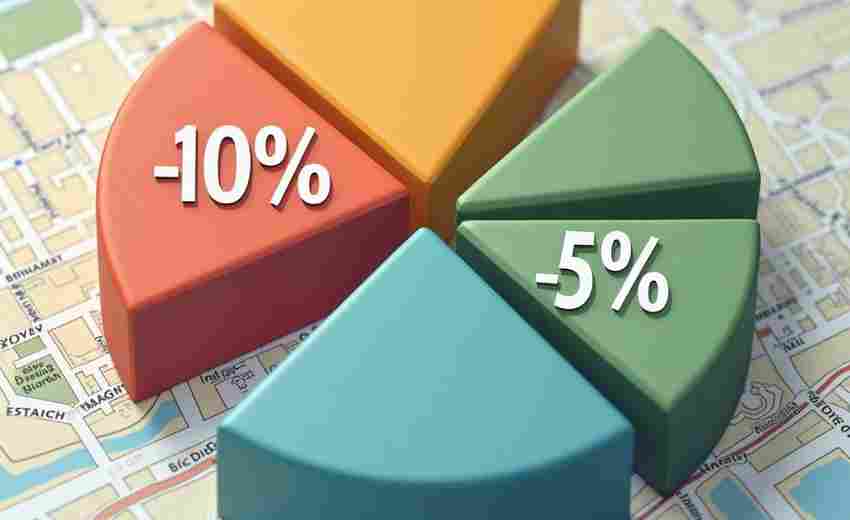

谷歌2024年核心算法更新特别强化了对关键词滥用的监测。SpamBrain系统通过机器学习模型,能够识别出刻意提高密度的"关键词岛"现象——即核心词汇被无关内容包围形成的异常文本结构。受此影响的网站,其搜索可见度在更新后平均下降63%。

算法惩罚不仅限于降低排名。在极端案例中,过度优化的页面会被标记为"低价值内容",导致整站权重受损。某外贸网站因将"工业阀门"密度提升至9%,引发算法对其50%页面的重新评估,最终流量流失达78%。这种惩罚具有持续效应,恢复周期往往需要6-12个月。

背离自然语言处理趋势

搜索引擎正从关键词匹配转向语境理解。谷歌的NLP API已能识别12种语义关系,包括同义词替换、概念延伸等复杂关联。在分析"新能源汽车保养"相关内容时,系统会重点关注"电池维护""充电桩使用"等衍生概念,而非机械统计"汽车"词频。

TF-IDF算法的普及改变了优化规则。该技术通过计算词项在文档集中的相对重要性,自动过滤高频但低价值的词汇。当多个页面同时出现异常密度时,算法会降低其权重系数。这意味着堆砌策略不仅无效,反而会稀释真正重要的语义信号。

优化策略的范式转换

优质内容应遵循"语义密度"原则,即在保持2-3%核心词频的基础上,构建包含30%以上相关术语的概念网络。针对"跨境电商运营"主题,有效内容需要自然融入"关税计算""海外仓管理""支付网关"等15-20个关联词汇,形成立体化的语义矩阵。

长尾关键词的合理配置能提升内容与搜索意图的契合度。将"关键词密度检测工具"扩展为"SEO内容优化中的词频平衡技巧",不仅降低核心词压力,还能覆盖更多长尾搜索场景。数据表明,这种策略可使目标关键词排名提升42%,同时带动15个相关长尾词进入前20位。