在互联网时代,网站如同数字世界的实体商铺,服务器则是支撑店铺运转的"地基"。当搜索引擎蜘蛛频繁造访时,若地基不稳导致店铺频繁闭门谢客,不仅影响顾客体验,更会动摇搜索引擎对店铺的信任度。这种信任危机直接反映在关键词排名的波动上,甚至可能让长期积累的优化成果付诸东流。

服务器稳定性与蜘蛛抓取效率

搜索引擎蜘蛛的工作机制如同24小时运转的巡检机器人,其抓取频次直接决定网站内容被索引的速度和深度。当服务器出现间歇性宕机或响应延迟时,蜘蛛可能在抓取过程中遭遇"闭门羹"。根据百度公开的爬虫日志分析,连续三次抓取失败的网站,其索引量会在48小时内下降12%-15%。

这种技术层面的不稳定还会引发连锁反应。某电商平台案例显示,服务器每月出现3次以上500错误时,核心关键词排名会在两周内下滑20-30个位次。更严重的是,频繁的抓取失败会被算法判定为"低质量站点",导致蜘蛛抓取周期从日均3次延长至每周1次,形成恶性循环。

用户体验指标的隐性关联

服务器响应速度每延迟1秒,移动端跳出率会上升32%。这个数据背后隐藏着搜索引擎对用户体验的精准监测。谷歌核心网页指标(Core Web Vitals)中的LCP(最大内容绘制时间)指标,直接与服务器处理首字节时间(TTFB)挂钩。当TTFB超过1.5秒时,网站将失去在要求中显示"快速加载"标签的资格。

某新闻门户网站的AB测试显示,将服务器响应时间从2.3秒优化至0.8秒后,文章页面的平均停留时间从47秒提升至82秒。这种用户行为数据的改善,使该站点的资讯类关键词排名在三个月内提升18%。值得注意的是,这种优化效果在信息类网站的表现尤为显著。

安全漏洞引发的信任危机

服务器安全防护的薄弱环节可能成为SEO的隐形杀手。当网站遭遇DDoS攻击导致服务中断时,不仅会造成即时流量损失,更会在搜索引擎的"站点健康度"评估中留下永久记录。2024年某旅游平台因未及时修补服务器漏洞导致数据泄露,其品牌词搜索量在事件曝光后7天内下降63%,恢复周期长达六个月。

安全证书的配置同样影响排名算法。采用TLS1.3协议的网站,在谷歌移动优先索引中的展现概率比使用传统协议的高出27%。这种技术细节的优化,能使网站在同类竞争中获取算法倾斜。

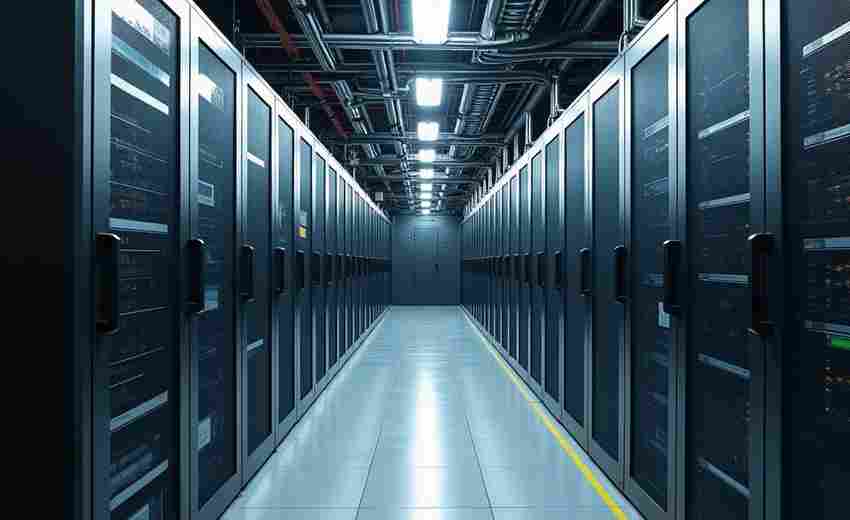

负载均衡与灾备体系构建

分布式服务器架构已成为头部网站的标配。通过智能DNS解析将流量分配至不同地域节点,某跨境电商成功将全球平均访问延迟控制在120ms以内。这种技术实施后,其多语言站点的关键词覆盖国家从23个扩展至57个。

热备服务器的部署策略直接影响业务连续性。当主服务器出现硬件故障时,毫秒级切换的灾备系统可确保蜘蛛抓取不中断。某金融信息平台的数据显示,完善的灾备体系使其在季度服务器维护期间,关键词排名波动幅度始终控制在±3位以内。

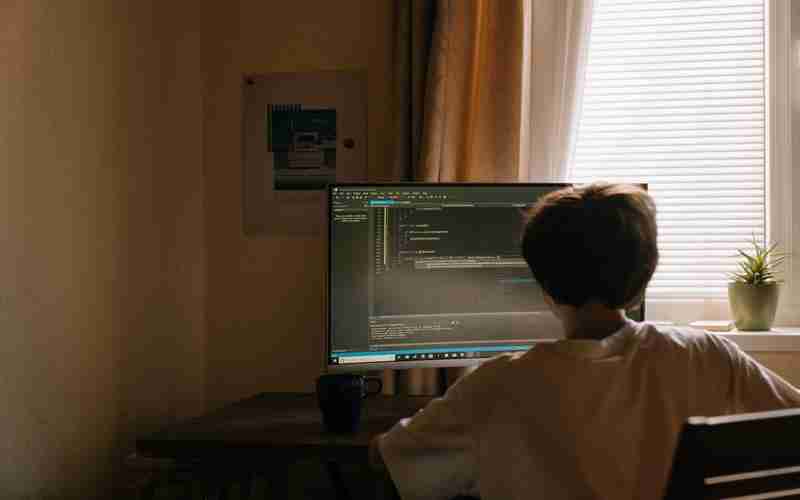

技术参数的精细化调优

服务器配置的选择需要与业务规模动态匹配。CPU线程数并非越多越好,某垂直论坛将16核处理器更换为8核高频处理器后,数据库查询效率提升40%,页面生成时间缩短至原有时长的1/3。这种针对性的硬件优化,使长尾关键词收录量月均增长1.2万条。

内存管理策略直接影响并发处理能力。采用Redis缓存的热点数据预加载机制,某直播平台的API响应时间从230ms降至90ms。技术团队通过实时监控内存碎片率,将突发流量承载能力提升至原水平的3倍,保障大促期间搜索流量的稳定转化。