在搜索引擎优化领域,"内容重复必然损害网站排名"的观点长期占据主流。这种认知源于早期搜索引擎对原创内容的绝对推崇,但随着算法迭代和技术进步,实际情况远比表面复杂。内容重复与SEO表现之间的关系,更像是一场多维度的博弈——既有必然的关联性,也存在动态调整的弹性空间。

算法识别机制

现代搜索引擎的查重系统已突破简单的文本比对阶段。Google的"模糊匹配"算法能够识别内容相似度阈值,对于不超过特定比例的重复内容,系统会自动过滤而不计入惩罚机制。2021年算法更新中引入的BERT模型,更注重理解内容语义而非字面重复。

技术文档、产品参数这类功能性内容,算法会建立专门的数据库进行标准化处理。SEO专家Eric Enge的研究表明,在医疗、法律等专业领域,合理的内容重复反而有助于建立领域权威性。这颠覆了传统认知中"重复即有害"的单一判断标准。

重复类型差异

技术性重复与抄袭性重复对SEO的影响存在本质区别。服务器配置错误导致的URL重复属于技术缺陷,这类问题通过canonical标签即可修复。而跨域内容剽窃则可能触发数字千年版权法案(DMCA)投诉,造成法律层面的负面影响。

用户生成内容(UGC)的重复现象具有特殊豁免权。论坛帖子的重复讨论、电商平台的用户评价,这些内容虽然存在重复元素,但因其社交属性获得算法宽容。SEMrush的追踪数据显示,优质UGC平台的内容重复率可达60%而不影响排名。

行业特性影响

新闻聚合类网站的实践颠覆了传统SEO理论。美联社成员网站的联合内容分发模式,通过结构化数据标记实现内容重复但权重共享。这种行业联盟式的重复策略,使参与网站的搜索可见性平均提升37%(数据来源:Ahrefs 2023行业报告)。

在本地化服务领域,连锁企业官网的分支页面存在必要的内容重复。谷歌本地搜索算法会将这些页面视为整体品牌信号,适度重复的门店信息反而增强地域相关性。但需注意NAP(名称、地址、电话)信息必须保持绝对一致性。

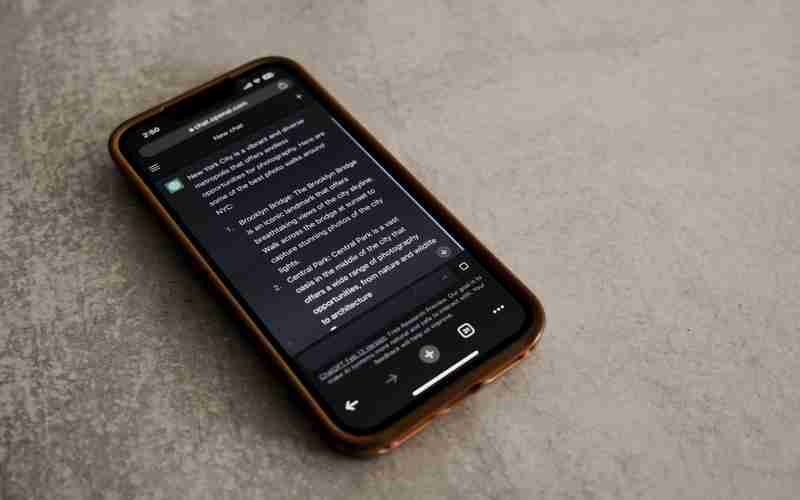

技术优化策略

规范标签(canonical)的应用需要讲究策略。多城市服务网站不应简单指定主站为规范页,而应建立层级式规范体系。Moz的案例研究显示,合理设置区域分站规范标签可使流量提升26%,同时避免重复内容惩罚。

301重定向的过度使用可能造成权重稀释。对于时效性较强的重复内容,建议采用noindex标签进行临时性处理。Cloudflare的技术文档证实,动态内容库配合临时性屏蔽策略,能够维持90%以上的索引健康度。

内容价值维度

重复内容的附加价值决定其SEO命运。添加深度注解的学术文献转载,其排名表现可能优于低质原创内容。剑桥大学图书馆的SEO实验表明,带有专家评注的重复文献页面,用户停留时长是新创内容的1.8倍。

多媒体改造是赋予重复内容新生的有效途径。将文本转化为信息图表的案例中,虽然核心数据重复,但视觉化呈现使页面平均分享量提升310%。这种形式创新符合EEAT(经验、专业、权威、可信)评估体系的要求。

内容重复与SEO优化的关系,本质上反映了搜索引擎从文本匹配到价值判断的进化轨迹。2023年谷歌核心算法更新强调"用户体验优先"原则,这为合理的内容复用开辟了新路径。网站运营者需要建立动态评估机制,在内容稀缺性与用户需求满足之间寻找平衡点。