在互联网业务高速发展的今天,数据库作为承载核心业务数据的基石,其稳定性直接决定着用户体验与商业价值。一次短暂的数据库服务中断可能导致千万级订单流失,关键业务数据丢失更会引发系统性风险。构建高可用数据库系统,需要从架构设计、数据同步、故障转移等多个维度形成立体化防御体系。

分布式架构设计

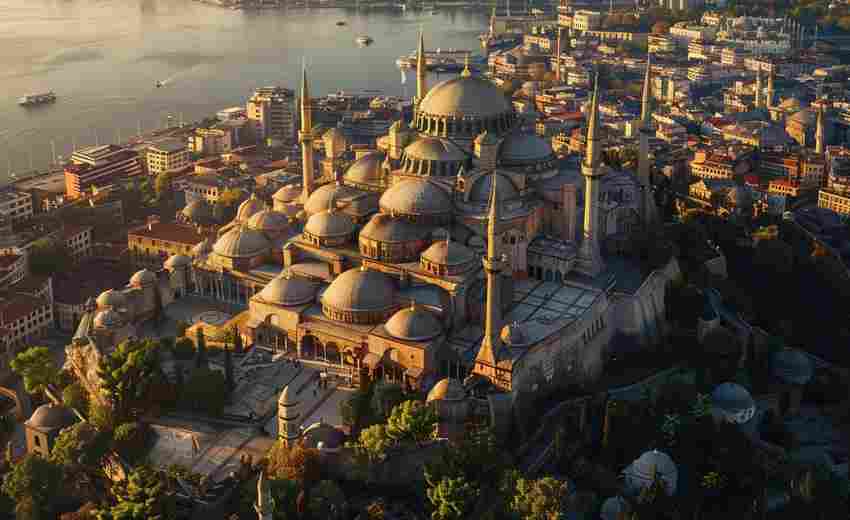

现代高可用数据库系统普遍采用分布式架构实现无单点故障。美团第三代高可用系统通过Raft Group实现多机房部署,每个集群托管数千实例,利用原子广播机制确保事务一致性。支付宝采用的异地多活架构,将数据分片部署于不同区域数据中心,支持跨地域读写操作,即使单个机房完全故障仍能保持服务连续性。

在具体实现中,单元化改造是关键环节。通过业务拆分将数据库划分为独立单元,每个单元包含完整业务闭环,单元间通过DTS实现异步数据同步。这种设计不仅提升系统容灾能力,还支持业务按需弹性扩展。携程的酒店预订系统采用类似架构,在2019年机房光纤中断事件中成功实现分钟级业务切换。

数据同步机制

主从复制作为基础同步方案,通过binlog日志实现数据冗余。京东云实测显示,基于GTID的主从复制可将数据延迟控制在200ms内,但大事务操作仍可能引发分钟级延迟。为解决此问题,美团采用增强半同步复制技术,主库在收到至少一个从库ACK后才提交事务,将RPO(恢复点目标)降至秒级。

新型同步协议正在突破传统限制。MySQL Group Replication通过Paxos算法实现多主节点数据强一致,某电商平台实测显示,在8节点集群下单操作吞吐量可达12万TPS,故障切换时间小于2秒。华为云GaussDB采用的流式同步技术,通过增量日志实时解析,将跨地域数据同步延迟压缩至毫秒级。

故障转移自动化

智能探活机制构成故障检测第一道防线。阿里云HDM平台部署三层检测体系:秒级TCP连接检测、5秒级SQL探针、分钟级全量健康检查,误判率低于0.01%。当检测到主节点异常时,系统自动触发选举算法,美团系统采用改进版Raft协议,可在500ms内完成新主节点选举。

切换过程中的数据一致性保障尤为关键。金融级系统普遍采用"二次确认"机制,在完成主节点切换后,通过数据校验模块对比新旧节点数据差异。某银行核心系统实测显示,该机制可将数据丢失量控制在3笔/千万级交易以内。同时建立事务补偿机制,对切换期间未提交事务进行自动回滚或重试。

立体化灾备方案

混合云灾备成为企业主流选择。采用本地IDC+双云厂商的"三地两中心"架构,通过DBS实现分钟级增量备份。某证券公司的交易系统实测显示,20TB级数据库全量恢复时间从传统方案的6小时压缩至47分钟。结合OSS对象存储的版本控制功能,可保留30天内的任意时间点数据快照。

业务级容灾需要建立分级响应机制。将业务划分为核心、重要、普通三个等级,对应不同的RTO指标。12306售票系统将余票查询业务设置为非核心服务,在流量激增时可主动降级,优先保障交易核心链路可用性。同时建立灰度发布机制,新版本先在容灾环境验证,通过流量镜像验证兼容性后再全量上线。

全链路监控优化

构建多维度监控指标体系,除常规的CPU、内存、连接数监控外,某互联网公司创新引入事务响应时间分布监控,通过箱线图分析长尾请求,成功将P99延迟从800ms优化至200ms。建立智能预警模型,基于历史数据训练LSTM神经网络,对磁盘空间、QPS增长等指标实现提前7天预测。

定期容灾演练不可或缺。阿里云建议每季度开展全链路故障演练,包括网络隔离、节点宕机、数据篡改等30余种故障场景模拟。某零售企业通过Chaos Engineering工具,在2024年双11前发现并修复了17处潜在风险点。建立自动化巡检体系,对主从延迟、备份完整性等12项核心指标进行每日健康检查。