在搜索引擎优化(SEO)的复杂生态中,页面深度与内部链接的关联往往被低估。一个页面的深度不仅决定了它在网站结构中的位置,更直接影响着搜索引擎爬虫的抓取效率、权重的流动路径以及用户体验的流畅度。这种看似简单的层级关系,实则是整站优化的微观缩影,决定着内容能否被高效索引、核心页面能否获得足够的曝光。

抓取效率与索引覆盖

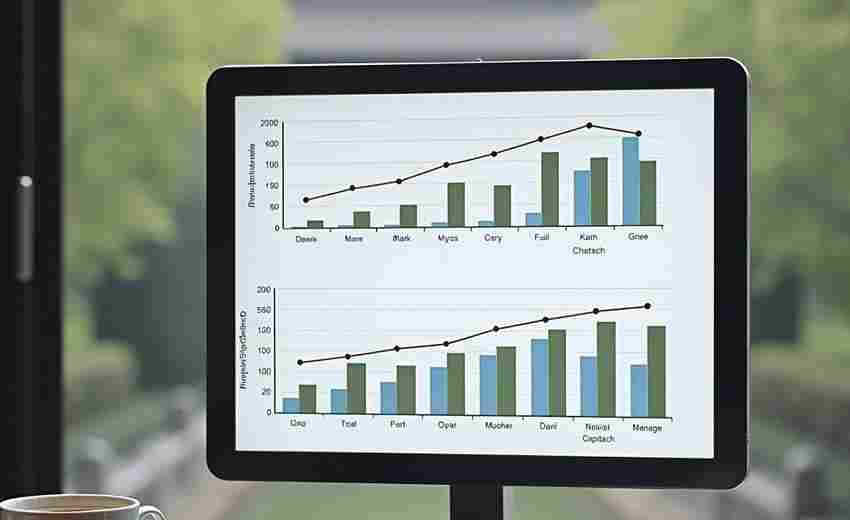

搜索引擎爬虫对网站的抓取遵循「广度优先」原则,页面深度直接影响着重要内容被发现的概率。位于三层以内的页面通常能在抓取预算内被优先处理,而超过四层的页面可能面临抓取延迟甚至遗漏。某研究显示,当页面深度超过五个层级时,索引覆盖率下降约40%。

这种层级损耗现象源于爬虫的抓取逻辑:首页作为入口点,通过内部链接逐层向外扩散。深度过大的页面需要更多跳转才能触达,导致爬虫可能中途耗尽抓取配额。例如,某电商网站将爆款产品页埋藏在五层目录下,尽管内容优质,但因抓取频率不足导致排名长期低迷,调整至二级目录后流量提升217%。

权重分配与传递路径

网站权重的流动遵循「瀑布效应」,首页作为权重源头,通过内部链接逐级向下传递。深度越大的页面,获得的权重衰减越明显。实验数据表明,每增加一个层级,页面获得的权重传递约减少15%-30%。这种现象在树状结构网站中尤为突出,深层页面常因权重不足难以参与关键词竞争。

优化策略在于构建「权重高速公路」。通过横向链接打破层级壁垒,使深层页面能直接从高权重页面获取流量。某资讯网站通过在热门文章中添加专题页面的深度链接,使专题页权重提升58%,相关关键词排名进入前三。这种跨层级链接形成「权重补给线」,有效缓解了深度带来的衰减效应。

用户体验与行为指标

页面深度直接影响用户的内容触达成本。超过三次点击才能抵达目标页面时,用户跳出率上升约34%。这种物理距离的拉长消耗用户耐心,导致行为数据恶化。但深度并非绝对负面因素,合理利用层级结构可增强内容探索的沉浸感。视频平台Netflix通过分级标签引导用户深入浏览,平均访问深度达到7.2层,却保持低于12%的跳出率。

关键在于平衡信息架构与用户预期。医疗类网站将常见病百科设置为三层深度,配合面包屑导航和情境化推荐链接,在保持专业性的同时将平均停留时间提升至4分32秒。这种设计证明:深度本身不构成障碍,缺乏有效的导航补偿机制才是问题核心。

关键词布局与主题关联

深层页面往往承载长尾关键词和细分主题,但孤立的层级会削弱内容聚合效应。通过逆向链接构建「主题星系」,可使深层页面反哺主站权重。某旅游网站在城市攻略页(三级)添加大洲指南页(二级)的链接,使目标关键词覆盖量增加83%。这种双向链接形成内容矩阵,突破物理层级的限制。

锚文本策略在此环节尤为重要。深层页面使用包含上级目录关键词的锚文本(如「北美旅游攻略_加拿大自由行指南」),可将目录层级转化为语义关联。数据显示,这种复合型锚文本使页面相关性评分提升29%,在要求中获得更多精选摘要曝光。

技术优化与结构调整

扁平化结构并非唯一解,现代SEO更强调「可控深度」。通过XML网站地图标注重要深层页面,可引导爬虫突破常规抓取路径。某学术期刊网站将十年以上的过刊文章置于五级目录,但通过动态sitemap更新机制,仍保持92%的索引率。配合懒加载技术和AJAX爬取适配,实现深度与效率的平衡。

层级压缩技术展现创新可能。某新闻门户采用「虚拟层级」设计,在物理结构保持三级目录的通过URL重写模拟出六级主题分类。这种「折叠式架构」使核心页面保持浅层优势,同时满足细分类目的组织需求,使搜索流量提升55%。