在搜索引擎优化(SEO)的实践中,关键词密度曾被视为提升排名的核心指标。但随着算法迭代,过度依赖这一指标逐渐成为一把双刃剑——不当的密度控制不仅无法实现流量增长,反而可能触发搜索引擎的防御机制,导致页面排名断崖式下滑。这种矛盾背后,折射出搜索引擎对内容价值的重新定义。

搜索引擎的惩罚机制

当关键词密度超过合理阈值时,页面可能被判定存在“关键词堆砌”行为。谷歌公开表示,其算法能识别通过机械化重复关键词操纵排名的行为,并会对这类页面进行降权处理。例如某电商平台因在商品描述中高频重复品牌词,导致页面在2024年算法更新后完全失去索引。

这种惩罚机制源于搜索引擎对用户体验的守护逻辑。算法通过语义分析模型检测关键词的自然分布状态,若发现异常密集的重复模式,系统会自动降低页面在相关搜索中的展现权重。部分案例显示,被标记为垃圾内容的页面恢复排名平均需要6-12个月的持续优化。

用户体验的实质损害

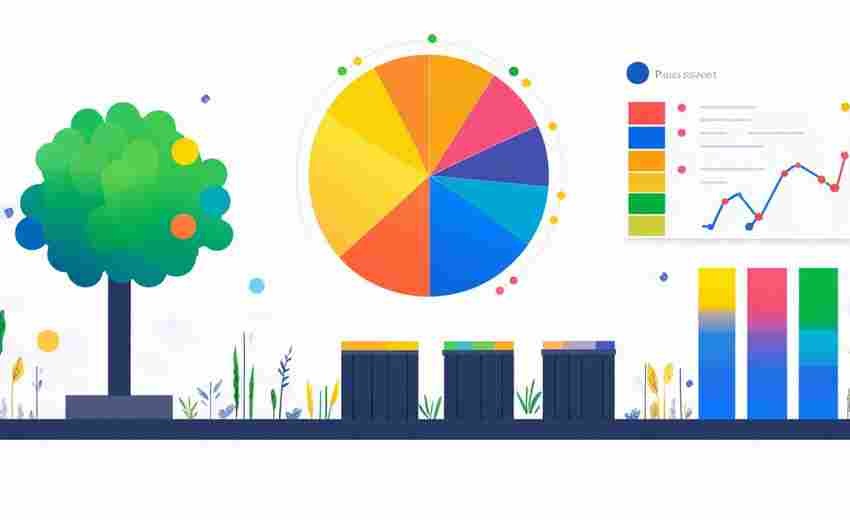

关键词堆砌最直接的危害是破坏内容的可读性。当用户发现段落中反复出现相同词汇时,阅读流畅性将被打断。某服装类独立站测试数据显示,关键词密度超过5%的页面跳出率较正常页面高出47%,平均停留时间缩短62%。

这种体验损害会形成负面循环。搜索引擎通过用户行为数据(如跳出率、停留时长)判断页面质量,低质量页面进一步丧失排名优势。更严重的是,用户可能对品牌产生信任危机——当消费者在技术文档中遭遇关键词堆砌,会质疑内容的专业度。

内容相关性的反向削弱

现代搜索引擎已突破简单的关键词匹配阶段。谷歌的BERT算法能够解析上下文语义关联,过度优化的关键词反而会干扰算法对页面主题的判断。例如某咖啡文化网站过度使用“咖啡豆”关键词,导致算法误判页面为商品销售类内容,错失文化科普类流量。

合理的内容构建应注重语义网络的搭建。通过LSI关键词(潜在语义索引词)的有机分布,既能增强主题相关性,又能避免机械重复。研究显示,融入3-5个相关语义词的文章,在长尾词排名中的表现比单一关键词优化的文章提升28%。

长期排名的不可逆风险

算法更新的持续迭代放大了密度控制不当的长期风险。2024年谷歌核心算法更新明确将“内容滥用”列为打击重点,采用AI批量生成的高密度关键词内容面临更高惩罚概率。某SEO监测平台数据显示,算法更新后关键词密度超过3.5%的页面,自然流量平均衰减达72%。

这种风险具有明显的滞后效应。部分页面可能在初期获得短暂排名提升,但随算法识别能力增强,最终难逃惩罚。更棘手的是,被降权页面的历史优化痕迹会进入搜索引擎的质量评估数据库,增加后续内容优化的难度。