在搜索引擎优化(SEO)的实践中,网站地图作为引导搜索引擎爬虫抓取内容的重要工具,其有效性直接影响网站的收录效率。许多网站管理员发现,即便精心制作了地图,搜索引擎依然无法识别或正确解析。这种现象背后往往涉及技术配置、格式规范、内容质量等多重因素。

技术配置错误

技术配置是网站地图被识别的首要门槛。以WordPress为例,使用Yoast SEO插件生成站点地图时,若未正确设置固定链接结构,可能导致站点地图URL返回404错误。此时需通过刷新永久链接或手动修改服务器配置文件(如.htaccess)解决路径重定向问题。部分服务器因权限设置限制搜索引擎爬虫访问站点地图文件,例如未开放sitemap.xml的读取权限,或防火墙规则误拦截爬虫IP,导致地图文件无法被检索。

另一常见问题是robots.txt文件配置不当。若robots.txt中未声明站点地图路径,或错误设置“Disallow”规则屏蔽了站点地图目录,搜索引擎爬虫将无法主动发现地图文件。根据Google官方指南,应在robots.txt内明确添加“Sitemap:

格式与协议不符

格式规范直接影响搜索引擎的解析能力。XML站点地图必须严格遵循定义的协议标准,例如使用UTF-8编码、正确闭合标签、避免特殊字符未转义等。实践中,部分工具生成的XML文件存在标签嵌套错误、日期格式不规范(如使用“2025/03/27”而非“2025-03-27”)等问题,这些细节错误会导致整个文件被搜索引擎忽略。

动态URL参数处理不当也是常见陷阱。当站点地图包含带有问号、等号的动态链接时,搜索引擎可能将其判定为重复内容。建议通过URL重写技术将动态路径转换为静态形式,例如将“product.php?id=123”优化为“/product/123/”。对于大型电商平台,可采用分页式站点地图索引,单个文件控制在50MB以内,避免触发搜索引擎的文件大小限制。

服务器与权限问题

服务器地理位置和响应速度对地图识别有隐性影响。使用境外服务器的中文网站,百度爬虫的抓取频率可能降低至境内服务器的1/3,导致地图文件提交后长期未被处理。此时可通过CDN加速或更换境内服务器提升响应效率。SSL证书缺失会触发浏览器安全警告,部分爬虫可能因此中止抓取流程。部署HTTPS并确保证书链完整,是提升站点地图可信度的基础措施。

权限配置错误同样值得警惕。虚拟主机环境下,若多个网站共享IP地址,可能因其他站点违规导致IP被搜索引擎拉黑,间接影响本站点地图的识别率。独立IP服务器不仅能规避此类风险,还可通过资源独占提升爬虫抓取效率。

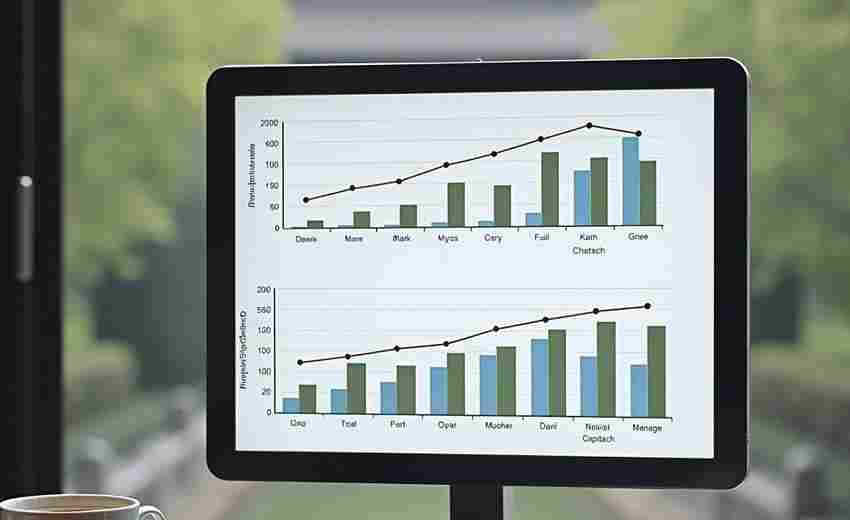

内容质量与更新频率

低质量内容会削弱站点地图的权威性。搜索引擎对采集内容、空白页面、死链率超过5%的站点地图采纳意愿显著降低。研究表明,含原创文章比例超过60%的地图文件,收录速度比纯采集内容快2.8倍。定期更新机制也至关重要,超过90天未更新的地图文件,搜索引擎可能降低其优先级,尤其对于新闻类网站,建议每日增量更新。

多媒体元素的优化常被忽视。根据Google官方文档,包含图片ALT标签、视频缩略图描述的增强型站点地图,可使多媒体内容收录率提升47%。但需注意,图片URL未使用绝对路径、视频时长未标注等细节问题,仍会导致部分内容无法被索引。