在电子商务行业飞速发展的浪潮中,淘宝作为中国最大的在线零售平台,其用户规模与交易量呈指数级增长。面对每秒数十万级的并发访问和海量数据处理需求,传统单机架构早已无法承载业务压力。淘宝通过一系列技术创新和架构演进,构建了一套成熟的高效水平扩展体系,实现了从单一服务到全球分布式系统的蜕变。

分布式架构转型

淘宝早期的单机架构在2008年前后遭遇性能瓶颈,单日交易峰值突破10亿元时系统频繁宕机。为解决这一问题,技术团队将核心业务拆分为商品、交易、用户等独立服务模块,每个模块部署在专用服务器集群上。这种拆分不仅降低了单点故障风险,更使得各业务线可根据负载独立扩展。

在服务拆分基础上,淘宝采用无状态设计原则,通过Session框架实现用户会话信息与业务逻辑解耦。例如订单处理服务不存储任何本地状态数据,所有请求均通过分布式缓存(如Redis)获取上下文信息。这种设计使得新增服务器节点时无需同步状态数据,系统扩展效率提升80%。

数据库分治策略

当商品数据突破百亿级时,传统关系型数据库出现严重性能瓶颈。淘宝创新性地采用分库分表技术,将单一数据库按商品类目拆分为256个子库,每个子库再根据卖家ID进行二次分表。通过自主研发的TDDL中间件,系统自动路由查询请求,使单表数据量控制在千万级以内。

针对非结构化数据的爆发式增长,淘宝在2012年引入HBase和MongoDB构建混合存储体系。例如用户行为日志采用HBase实现毫秒级写入,商品详情页的JSON数据通过MongoDB支撑灵活查询。这种分层存储方案使系统整体吞吐量提升4倍,同时降低30%的硬件成本。

微服务化改造

2015年双十一期间,淘宝核心系统调用链复杂度激增,单一服务故障可能引发级联崩溃。为此,技术团队启动微服务化改造,将支付系统拆分为风控、清算、通知等15个独立服务,并引入Dubbo框架实现服务治理。改造后系统故障隔离率达到99.7%,服务重启时间从分钟级缩短至秒级。

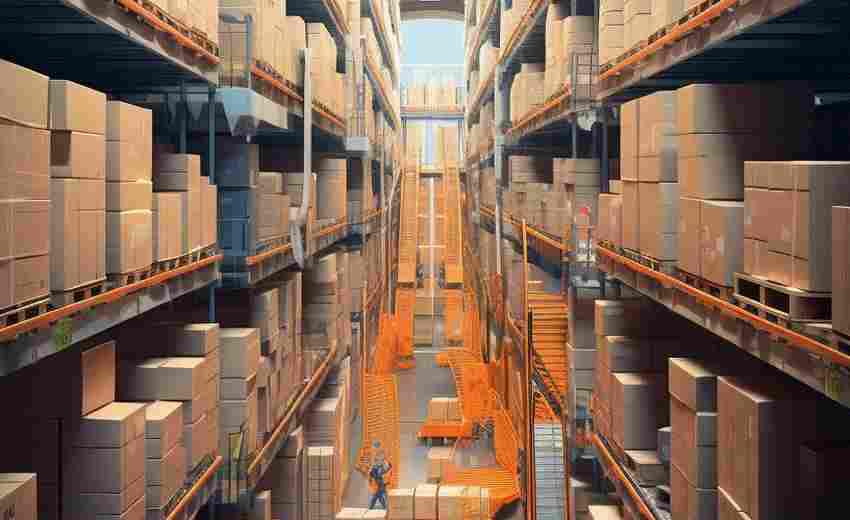

容器化技术的应用进一步提升了扩展效率。通过自研的Sigma调度系统,淘宝将微服务打包为Docker镜像,配合Kubernetes实现分钟级千台服务器扩容。在2024年双十二大促中,该系统成功支撑了150万台容器的并发调度,资源利用率提升至65%。

弹性伸缩机制

为应对突发流量,淘宝构建了智能弹性伸缩体系。基于实时监控数据,系统可预测未来5分钟的负载变化,自动触发服务器扩容操作。例如秒杀活动开始时,商品详情服务会在30秒内完成从200台到5000台服务器的水平扩展。

流量调度系统采用多层次负载均衡策略,在全局层面使用LVS实现跨机房流量分发,在集群内部通过Nginx进行请求分配。结合TCP协议优化和连接池管理,该系统将网络延迟控制在5ms以内,2024年双十一期间成功处理了1.5亿次/秒的HTTP请求。

缓存体系优化

淘宝构建了四级缓存体系应对读多写少的业务特性。客户端本地缓存保存静态资源,CDN节点缓存热点页面,服务端采用Redis集群缓存业务数据,最后层才是数据库查询。这种架构使商品详情页的缓存命中率达到98%,数据库查询压力下降90%。

在缓存更新策略上,淘宝首创"预加载+异步失效"机制。当某个商品被加入购物车超过1000次时,系统自动将该商品数据预热到所有区域缓存节点。同时通过订阅数据库binlog实现缓存实时更新,将数据一致性延迟控制在200ms以内。