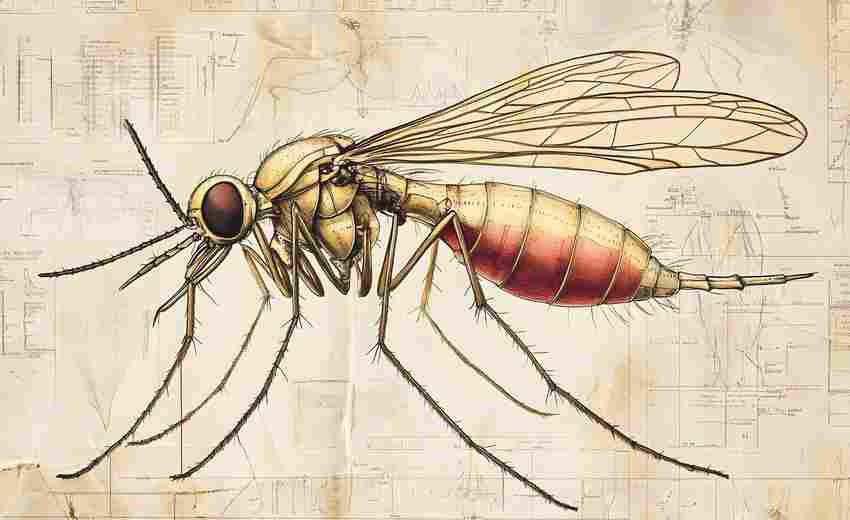

在数字时代的浪潮中,搜索引擎如同无形的图书馆员,通过精密算法构建着全球信息的索引体系。而蜘蛛爬虫作为这个体系的“信息采集员”,其抓取效率与质量直接决定了网页能否被搜索引擎“看见”,进而影响排名与流量。理解蜘蛛的运作逻辑,已成为网站突破流量瓶颈的核心密码。

爬虫的抓取逻辑

蜘蛛爬虫的本质是自动化程序,通过超链接的蛛网式延伸,不断发现并收录互联网内容。当爬虫首次接触网站时,会优先检索robots.txt文件,这份“访问守则”决定了哪些页面允许被抓取,哪些需要屏蔽。例如电商平台常利用该文件限制爬虫访问敏感促销页面,避免服务器过载。

抓取频率受网站权重与更新周期双重影响。权威新闻网站可能被百度蜘蛛每小时访问,而低频更新的企业官网可能每周仅被索引一次。这种差异源于搜索引擎的智能调度算法,它会根据历史数据预测内容更新概率,动态调整资源分配。

链接网络的构建

链接是蜘蛛导航的核心路径,如同城市道路系统般支撑着抓取效率。内部链接的合理布局能引导爬虫深入网站“腹地”,将原本孤立的页面串联成有机整体。研究表明,三层以内点击深度的页面被收录概率比深层页面高出73%。

外部链接则如同其他网站的“推荐信”,高质量外链不仅能传递权重,更会触发爬虫的跨域抓取行为。例如维基百科的权威链接常带动被引用网站的新页面快速收录。但垃圾链接的负面效应同样显著,2019年某医疗网站因购买低质外链导致索引量暴跌82%,印证了链接质量的重要性。

内容质量的核心地位

蜘蛛抓取不仅是机械的内容复制,更包含语义分析与质量评估。谷歌的BERT算法已能理解段落间的逻辑关联,识别低质内容的准确率达91%。某旅游博客的实验显示,深度攻略类文章的平均抓取频率是碎片化资讯的2.3倍,印证了内容深度的价值。

原创性检测机制通过比对数十亿网页数据库,能在毫秒级识别重复内容。2024年百度推出的“清风算法”中,原创文章的初始权重分比采集内容高出40%,这种差异直接体现在收录速度与排名稳定性上。

技术优化的底层支撑

页面加载速度超过3秒会使抓取请求减少58%,这个数据来自谷歌2023年的爬虫日志分析。服务器响应时间的毫秒级优化,能显著提升每日抓取量。某电商平台通过CDN节点优化,使Googlebot抓取效率提升37%,同期自然流量增长19%。

结构化数据的应用让内容解析效率提升60%。采用Schema标记的电商产品页,其价格、库存等信息被提取准确率高达99%,这种机器友好型编码大幅降低了搜索引擎的理解成本。

动态内容的适配挑战

JavaScript渲染内容曾导致42%的页面元素无法被抓取,这个痛点促使搜索引擎升级渲染引擎。谷歌2024年更新的爬虫内核已能执行90%的常见JS脚本,但异步加载内容仍需配合预渲染技术。某新闻门户通过SSR改造,使动态评论区的收录率从31%跃升至89%。

移动优先索引策略下,响应式设计成为标配。百度蜘蛛的移动版爬虫抓取量占比从2020年的54%升至2024年的92%,页面移动适配度每提升10%,核心关键词排名平均前进2.3位。