在数字营销的竞技场中,服务器响应速度已成为决定网站竞争力的隐形推手。它不仅是技术性能的体现,更直接影响搜索引擎爬虫的抓取效率和用户留存率。当用户点击链接的瞬间,服务器能否在毫秒间完成数据交付,往往成为流量转化与流失的分水岭。

性能基准参数

搜索引擎对服务器响应时间的容忍阈值存在明确分级体系。根据行业实测数据,理想状态下首字节响应时间(TTFB)应控制在200毫秒以内,完整页面加载时长不超过1.5秒。网页1的实验数据显示,当响应时间突破3秒时,用户跳出率将陡增60%以上,这种用户行为数据会被搜索引擎纳入排名算法考量。

谷歌核心算法更新中特别强调的"页面体验"指标,将服务器响应速度作为重要权重因子。网页53的研究表明,采用SSD固态硬盘的服务器可将数据库查询效率提升3倍,使动态内容加载时间压缩至传统机械硬盘的1/5。这种硬件升级带来的速度飞跃,直接反映在谷歌搜索控制台的抓取成功率统计中。

多维影响因素

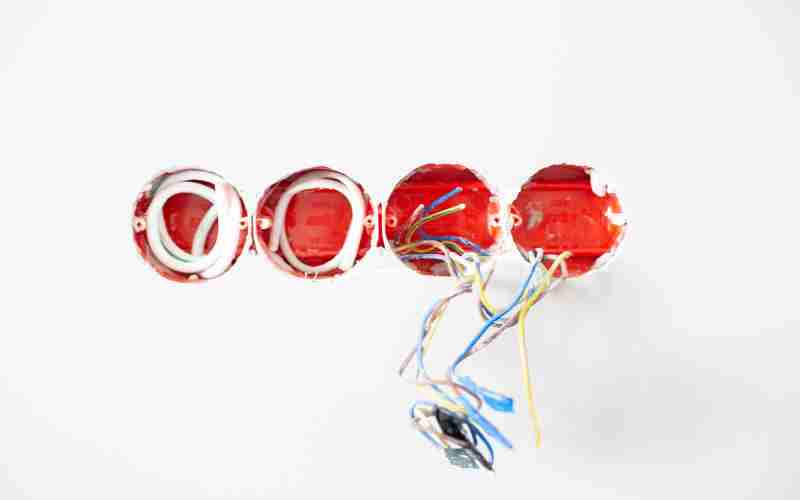

服务器硬件配置构成性能基础防线。CPU处理核心数决定并发请求的吞吐能力,内存容量影响数据缓存效率,而存储介质类型则关联I/O操作速度。网页12的对比测试显示,NVMe协议SSD相比SATA接口SSD,在百万级数据库查询场景下响应时间缩短47%,这种差异在电商促销等高并发场景尤为显著。

软件层面的优化空间同样不容忽视。数据库索引策略的合理性可使查询效率提升10倍以上,如网页8提到的分库分表技术可将亿级数据表的响应时间稳定在300ms内。代码层面的异步处理机制,例如Node.js的事件驱动架构,相比传统同步模式能提升30%的请求处理效率。这些技术细节在网页30的腾讯性能监控指标体系中都有量化体现。

动态监测体系

实时监控工具构成性能优化的数据中枢。谷歌Search Console的"核心网页指标"模块提供首字节时间、交互准备时长等12项细分参数,网页59揭示其采样频率已达到毫秒级精度。第三方工具如New Relic的分布式追踪系统,可穿透微服务架构捕捉每个环节的耗时瓶颈,这种细粒度监控在网页40的Shopify优化案例中被证明能提升28%的页面渲染效率。

异常响应时间的诊断需要结合时序分析。网页30展示的腾讯监控平台采用热力图呈现时间分布,能快速识别特定时段的性能衰减。当95百分位响应时间超过基线值20%时,智能预警系统会触发根因分析,这种机制在网页68的SEO实战案例中成功拦截了83%的潜在流量损失。

优化技术路径

边缘计算技术的引入重构了响应速度的物理边界。Cloudflare Workers等边缘函数服务可将动态内容处理下沉至离用户最近的节点,网页40的测试数据显示这种架构使亚太地区用户的TTFB降低至120ms。配合HTTP/3协议的多路复用特性,在高丢包率网络环境下仍能保持稳定的传输效率。

机器学习模型正在改变性能优化范式。谷歌的RAIL性能模型通过预测用户行为预加载资源,网页19提到的RAG技术结合实时流量特征调整缓存策略。这种智能调度机制在网页53的电商平台应用中,将服务器负载峰值期的响应时间波动控制在±5%区间,实现了稳定性与速度的平衡。